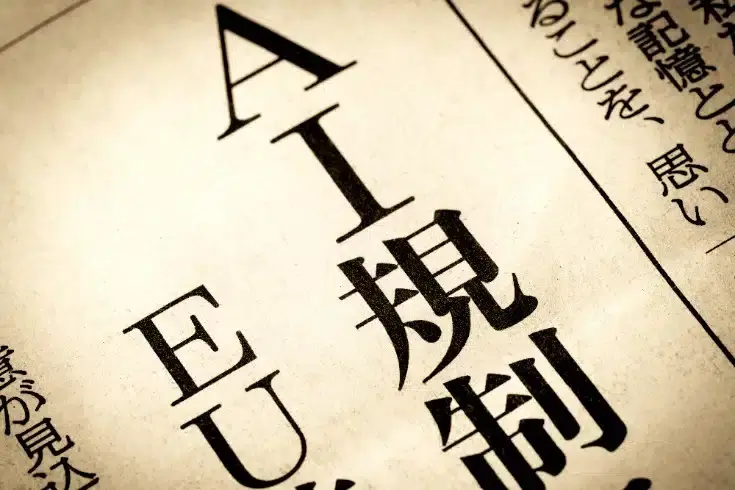

Peraturan AI EU dan Tindak Balas yang Perlu bagi Syarikat Jepun

Pada 12 Julai 2024 (2024年7月12日), ‘Undang-Undang Pengaturan AI (EU AI Act)’ telah diumumkan di EU, dan mulai dikuatkuasakan pada 1 Ogos tahun yang sama.

Undang-undang ini mengatur penggunaan dan penyediaan sistem AI di dalam wilayah EU, dan mulai tahun 2025, ia juga akan menuntut tindakan tertentu dari syarikat-syarikat Jepun.

Secara spesifik, sama seperti pengendali laman web e-dagang di Jepun yang perlu mematuhi ‘Peraturan Perlindungan Data Umum (GDPR)’ EU, syarikat-syarikat Jepun yang menyediakan produk atau perkhidmatan berkaitan AI kepada pelanggan di dalam wilayah EU juga mungkin akan tertakluk kepada Undang-Undang Pengaturan AI EU.

Di sini, kami akan menjelaskan tentang klasifikasi risiko sistem AI dan penilaian kesesuaian yang diperlukan oleh perniagaan yang terlibat, serta cara untuk mematuhi peraturan yang diperkenalkan bersamaan dengan pelaksanaan undang-undang ini.

Prasyarat: Perbezaan Antara ‘Peraturan’ dan ‘Arahan’ dalam Undang-Undang EU

Sebelum menerangkan mengenai Undang-Undang Pengaturan AI itu sendiri, sebagai prasyarat, kita perlu memahami perbezaan antara ‘Peraturan’ dan ‘Arahan’ dalam undang-undang EU.

Pertama, ‘Peraturan’ adalah undang-undang yang terpakai secara langsung kepada negara-negara anggota, syarikat, dan lain-lain entiti di dalam EU. Ini bermakna, ‘Peraturan’ mempunyai keutamaan terhadap undang-undang domestik negara-negara anggota EU dan diterapkan secara seragam di seluruh wilayah EU. Oleh itu, apabila ‘Peraturan’ dikuatkuasakan, negara-negara anggota EU akan mengalami penerapan kandungan peraturan yang sama.

Sebaliknya, ‘Arahan’ adalah undang-undang yang bertujuan untuk menyelaraskan dan menyatukan kandungan peraturan di antara negara-negara anggota EU. Namun, ‘Arahan’ pada dasarnya tidak terpakai secara langsung kepada negara-negara anggota, dan setiap negara perlu menggantikan kandungan yang ditetapkan dalam ‘Arahan’ ke dalam undang-undang domestik mereka sendiri. Biasanya, negara-negara harus melaksanakan atau mengubah undang-undang domestik mereka dalam tempoh tiga tahun selepas ‘Arahan’ diterbitkan dalam Jurnal Rasmi EU.

Ciri khas ‘Arahan’ adalah bahawa ia memberikan diskresi tertentu kepada negara-negara anggota ketika mengubahnya menjadi undang-undang domestik, yang menyebabkan perbezaan dalam kandungan undang-undang di setiap negara. Ini bermakna, undang-undang yang berdasarkan ‘Arahan’ tidak sepenuhnya seragam di seluruh EU, dan mungkin terdapat perbezaan kecil antara negara-negara.

Berdasarkan perbezaan ini, Undang-Undang Pengaturan AI telah diperkenalkan sebagai ‘Peraturan’. Ini bermakna, Undang-Undang Pengaturan AI terpakai secara langsung kepada entiti perniagaan yang berlokasi di dalam wilayah EU.

Artikel berkaitan: Panduan Penting untuk Syarikat yang Ingin Mengembangkan Perniagaan ke Eropah: Poin Utama Mengenai Undang-Undang dan Sistem Perundangan EU[ja]

Undang-Undang Pengawalseliaan AI dan Aplikasi Luar Wilayah di Jepun

Apakah Aplikasi Luar Wilayah?

‘Aplikasi Luar Wilayah’ merujuk kepada situasi di mana undang-undang yang diperkenalkan oleh sebuah negara diterapkan juga kepada tindakan yang berlaku di luar wilayah kedaulatan negara tersebut. Pengakuan aplikasi luar wilayah ini berlatarbelakangkan globalisasi ekonomi dan internasionalisasi aktiviti korporat, dengan tujuan untuk memastikan aktiviti ekonomi dunia dijalankan secara adil dan tepat.

Contoh yang menjadi titik tolak pengakuan konsep ini secara meluas adalah GDPR (Peraturan Perlindungan Data Umum EU). Di bawah GDPR, walaupun perusahaan yang tidak memiliki basis di EU, mereka masih boleh terkena aplikasi undang-undang ini (aplikasi luar wilayah) jika memenuhi syarat-syarat berikut:

- Menyediakan perkhidmatan atau produk kepada individu di dalam wilayah EU

- Mengolah data peribadi dengan tujuan memantau tingkah laku individu yang berada di dalam wilayah EU

Sebagai contoh, dalam kes di mana syarikat di luar EU menghantar pekerja mereka dalam perjalanan perniagaan ke EU dan mengolah data peribadi yang berkaitan selama tempoh tersebut, garis panduan tahun 2020 telah menyatakan ini sebagai ‘di luar aplikasi’, walaupun pada mulanya aplikasi luar wilayah telah dibincangkan.

Aplikasi Luar Wilayah dalam Undang-Undang Pengawalseliaan AI EU

Dalam Undang-Undang Pengawalseliaan AI EU, aplikasi luar wilayah juga diakui untuk perusahaan yang berlokasi di luar EU. Perusahaan atau aktiviti berikut adalah subjek kepada undang-undang ini:

- Pembekal (Providers): Mereka yang mengembangkan sistem AI atau model GPAI, yang memasarkan sistem AI atau model GPAI yang dikembangkan, atau yang memulakan operasi sistem AI dengan nama atau tanda dagangan mereka sendiri

- Pengguna (Users): Mereka yang menggunakan sistem AI di bawah otoritas mereka sendiri (kecuali penggunaan sistem AI untuk aktiviti peribadi dan bukan profesional)

- Pengimport (Importers): Pengimport yang berlokasi atau didirikan di dalam EU yang memasukkan sistem AI dengan nama atau tanda dagangan orang atau badan hukum yang didirikan di luar EU ke dalam pasaran EU

- Pengedar (Distributers): Orang atau badan hukum yang bukan pembekal atau pengimport, yang merupakan bagian dari rantai pasokan yang menyediakan sistem AI ke pasaran EU

Seperti yang dijelaskan di atas, walaupun perusahaan berlokasi di luar EU, jika mereka menyediakan, mengoperasikan, mengimport, atau menggunakan sistem AI atau model GPAI di dalam wilayah EU, maka Undang-Undang Pengawalseliaan AI EU akan diterapkan secara langsung kepada mereka.

Ciri-ciri Undang-Undang Peraturan AI EU: Pendekatan Berasaskan Risiko

Apakah Pendekatan Berasaskan Risiko?

Ciri terbesar undang-undang peraturan AI EU adalah penerapan ‘peraturan berdasarkan kandungan dan tahap risiko’ (pendekatan berasaskan risiko).

‘Pendekatan berasaskan risiko’ merujuk kepada kaedah penyesuaian kekuatan peraturan berdasarkan kandungan dan tahap risiko. Dengan pendekatan ini, keketatan peraturan yang dikenakan terhadap sistem AI ditentukan berdasarkan keparahan risiko yang mungkin ditimbulkannya.

Secara spesifik, sistem AI yang mempunyai risiko tinggi akan dikenakan peraturan yang lebih ketat, sementara sistem dengan risiko rendah akan dikenakan peraturan yang lebih longgar. Ini memungkinkan untuk mengelakkan peraturan yang berlebihan terhadap sistem dengan risiko rendah dan sebaliknya, memastikan pengawasan dan pengurusan yang sesuai untuk sistem dengan risiko tinggi.

Sistem AI dengan Risiko yang Tidak Boleh Diterima di Bawah Undang-Undang Jepun

Pertama sekali, sistem AI yang dianggap mempunyai risiko yang tidak boleh diterima dianggap sebagai ancaman kepada orang ramai dan secara prinsipnya dilarang di Jepun.

Sebagai contoh, sistem AI yang memanipulasi pengenalan atau tingkah laku pengguna daripada kumpulan yang rentan, seperti mainan yang diaktifkan suara yang mendorong tingkah laku berbahaya kanak-kanak, termasuk dalam kategori ini. Sistem penilaian sosial yang mengklasifikasikan orang berdasarkan tingkah laku, status sosioekonomi, atau ciri peribadi juga merupakan subjek larangan. Selain itu, sistem pengesahan biometrik ‘real-time dan remote’ yang menggunakan teknologi pengenalan wajah untuk mengidentifikasi individu dari jauh dengan membandingkan data biometrik manusia dengan pangkalan data rujukan juga secara prinsip dilarang.

Namun, terdapat pengecualian di mana penggunaan sistem-sistem ini dibenarkan. Secara khusus, sistem pengesahan biometrik real-time dan remote hanya dibenarkan digunakan dalam kes-kes kejadian serius yang terhad. Sebaliknya, sistem pengesahan biometrik remote yang digunakan selepas kejadian hanya dibenarkan dengan persetujuan mahkamah untuk tujuan mendakwa jenayah serius.

Lebih lanjut, sebagai pengecualian yang boleh dilaksanakan, terdapat situasi seperti mencari individu yang mungkin menjadi mangsa jenayah seperti kanak-kanak yang hilang, mencegah ancaman konkret dan mendesak terhadap keselamatan nyawa atau badan manusia dan serangan pengganas, serta mengesan pelaku atau suspek jenayah serius dan menentukan lokasi mereka. Pengecualian ini dikenakan pembatasan ketat yang memerlukan kebenaran mahkamah sebelumnya sebagai prinsip, dan penggunaan sistem AI memerlukan pengendalian yang berhati-hati.

Sistem AI Berisiko Tinggi di Jepun

Seterusnya, sistem AI yang diklasifikasikan sebagai sistem AI berisiko tinggi adalah sistem AI yang berpotensi memberi kesan buruk terhadap keselamatan atau hak asasi manusia. Penggunaan sistem ini dibenarkan apabila memenuhi keperluan dan kewajipan tertentu (penilaian kesesuaian).

Sistem AI berisiko tinggi ini terbahagi kepada dua kategori utama. Pertama, sistem AI yang digunakan dalam produk yang tercakup di bawah undang-undang keselamatan produk EU, termasuklah mainan, penerbangan, automotif, peralatan perubatan, dan lif. Kedua, sistem AI yang tergolong dalam bidang tertentu yang pendaftarannya diwajibkan dalam pangkalan data EU. Bidang ini merangkumi pengurusan dan operasi infrastruktur penting, pendidikan dan latihan vokasional, pengurusan pekerjaan dan pekerja, akses kepada perkhidmatan awam dan manfaat penting, penguatkuasaan undang-undang, imigrasi dan suaka, pengurusan sempadan, serta sokongan dalam interpretasi dan aplikasi undang-undang.

Sistem AI berisiko tinggi memerlukan penilaian sebelum memasuki pasaran dan sepanjang kitaran hayatnya. Selain itu, hak untuk membuat aduan mengenai sistem AI kepada pihak berkuasa negara yang ditetapkan juga diakui.

Secara umumnya, mesin dan kenderaan yang keselamatan hidup dan badan manusia menjadi keutamaan adalah sasaran sistem AI berisiko tinggi. Sebagai contoh, AI pemanduan automatik juga boleh termasuk dalam kategori ini, oleh itu, apabila syarikat Jepun mengembangkan AI pemanduan automatik untuk pasaran luar negeri, mereka perlu mempertimbangkan dengan teliti sama ada memenuhi keperluan sebagai AI berisiko tinggi dan bertindak balas dengan sewajarnya.

Sistem AI dengan Risiko Terbatas di Jepun

Di Jepun, sistem AI yang memiliki risiko terbatas ini dianggap melibatkan risiko transparansi, serta risiko peniruan, manipulasi, dan penipuan. Secara khusus, chatbot, deepfake, dan AI generatif termasuk dalam kategori ini, dan menurut pandangan Parlimen EU, sebahagian besar sistem AI yang digunakan saat ini diklasifikasikan ke dalam kategori ini. Contohnya termasuk sistem terjemahan automatik, konsol permainan, robot yang menjalankan proses pengeluaran berulang, dan juga sistem AI seperti ‘Mesin Eureka’.

Untuk AI generatif, walaupun tidak diklasifikasikan sebagai berisiko tinggi, tetap diperlukan untuk mematuhi keperluan transparansi dan undang-undang hak cipta EU. Tindakan khusus yang diperlukan adalah seperti berikut:

- Secara jelas mendedahkan bahawa kandungan telah dihasilkan oleh AI

- Mereka bentuk model untuk mengelakkan penghasilan kandungan yang melanggar undang-undang

- Membuka maklumat ringkas tentang data yang dilindungi hak cipta yang digunakan untuk melatih AI

Lebih lanjut, model AI umum yang canggih dan berpengaruh seperti ‘GPT-4’ (model GPAI) mungkin membawa risiko sistemik, sehingga memerlukan penilaian yang menyeluruh. Selain itu, jika insiden serius berlaku, ada kewajiban untuk melaporkan kepada Komisi Eropa. Tambahan pula, kandungan yang dihasilkan atau diubah menggunakan AI (seperti gambar, audio, fail video, deepfake, dan lain-lain) harus dengan jelas menunjukkan bahawa ia dihasilkan oleh AI, agar pengguna dapat mengenali kandungan tersebut dengan tepat.

Sistem AI dengan Risiko Minimum di Jepun

Akhir sekali, berkenaan dengan sistem AI yang mempunyai risiko minimum di Jepun, tidak ada peraturan khusus yang ditetapkan. Sebagai contoh konkret, kita boleh menyebut penapis spam dan sistem cadangan. Dalam kategori ini, bukannya peraturan yang ditekankan, tetapi pembangunan dan pematuhan kepada kod tingkah laku yang digalakkan.

Keperluan dan Kewajipan Sistem AI Berisiko Tinggi di Jepun

Kewajipan Pembekal, Pengguna, Pengimport, dan Penjual

Berdasarkan pengkategorian yang disebutkan, sistem AI berisiko tinggi khususnya dikenakan peraturan yang lebih ketat kerana keseriusan risikonya, dan pembekal serta pengguna diberikan kewajipan-kewajipan tertentu.

Pertama sekali, pembekal, pengguna, pengimport, dan penjual diwajibkan untuk membina sistem pengurusan risiko (Perkara 9). Ini melibatkan pembinaan dan pelaksanaan sistem untuk mengenal pasti dan mengurus risiko yang terkandung dalam sistem AI berisiko tinggi, serta mendokumentasikan dan memelihara sistem tersebut. Berkaitan dengan tadbir urus data (Perkara 10), penggunaan set data pembelajaran, pengesahan, dan ujian yang memenuhi piawaian kualiti diperlukan. Ini kerana kualiti dan kebolehpercayaan data harus dikelola dengan ketat bahkan pada tahap pembangunan sistem AI.

Selanjutnya, pembinaan dokumen teknikal juga diwajibkan (Perkara 11). Dokumen teknikal ini harus mengandungi maklumat yang diperlukan untuk membuktikan bahawa sistem AI berisiko tinggi mematuhi keperluan peraturan, dan harus disediakan untuk dapat diserahkan kepada agensi yang berwenang di negara anggota atau badan sertifikasi pihak ketiga. Selain itu, perancangan dan pembangunan fungsi log yang merekodkan kejadian secara automatik semasa sistem AI beroperasi juga diperlukan (Perkara 12). Sistem AI berisiko tinggi juga wajib didaftarkan dalam pangkalan data yang dikendalikan oleh EU sebelum diperkenalkan ke pasaran, dan pembekal bertanggungjawab untuk menyediakan dan memelihara sistem pengurusan kualiti yang didokumentasikan.

Kewajipan Pembekal

Pembekal diwajibkan untuk menyimpan dokumen teknikal, dokumen berkaitan sistem pengurusan kualiti, kelulusan atau keputusan oleh badan sertifikasi pihak ketiga, dan dokumen berkaitan lain selama 10 tahun selepas pengenalan ke pasaran atau permulaan operasi, dan mengemukakannya atas permintaan daripada pihak berkuasa domestik. Dengan ini, pembekal mempunyai tanggungjawab untuk memelihara kualiti dan keselamatan sistem AI dalam jangka panjang dan memastikan ketelusan.

Kewajipan Pengguna

Sebaliknya, pengguna juga dikenakan kewajipan-kewajipan tertentu yang berkaitan dengan penggunaan sistem AI berisiko tinggi. Pengguna diwajibkan untuk menyimpan log yang dihasilkan secara automatik oleh sistem AI berisiko tinggi untuk tempoh yang sesuai dengan tujuan yang dimaksudkan oleh sistem AI tersebut, kecuali ada peraturan khusus dalam undang-undang EU atau negara anggota, dan sekurang-kurangnya selama enam bulan.

Di samping itu, apabila memulakan operasi atau menggunakan sistem AI berisiko tinggi di tempat kerja, pengguna yang juga merupakan majikan diwajibkan untuk memberitahu wakil pekerja dan pekerja yang terjejas terlebih dahulu tentang penggunaan sistem tersebut. Ini ditetapkan dari sudut pandangan perlindungan hak pekerja dan penjaminan ketelusan.

Dengan demikian, sistem AI berisiko tinggi menetapkan keperluan dan kewajipan yang ketat bagi kedua-dua pembekal dan pengguna. Terutamanya dalam menangani teknologi AI canggih seperti peralatan perubatan atau sistem pemanduan automatik, kesesuaian dengan kerangka peraturan yang ada juga harus dipertimbangkan, dan dalam beberapa kes, penilaian kesesuaian dan peninjauan oleh badan sertifikasi pihak ketiga diperlukan, sehingga perusahaan harus bertindak dengan hati-hati dan terancang.

Jadual Pelaksanaan Berperingkat Undang-Undang Pengawalseliaan AI di Jepun

Undang-Undang Pengawalseliaan AI di EU ditetapkan untuk dilaksanakan secara berperingkat dari pengumuman hingga penerapan. Ini memerlukan para pengusaha untuk membuat persiapan dan tindak balas yang sesuai pada setiap peringkat.

Pada 12 Julai 2024, Undang-Undang Pengawalseliaan AI telah diumumkan dalam Warta Rasmi, dan dilaksanakan pada 1 Ogos tahun yang sama. Pada peringkat ini, pengusaha dikehendaki untuk memeriksa dan mempertimbangkan kandungan peraturan tersebut.

Pada 2 Februari 2025, peruntukan berkaitan ‘Prinsip Umum’ dan ‘Sistem AI dengan Risiko yang Tidak Dapat Diterima’ akan diterapkan. Sekiranya pengusaha menangani Sistem AI dengan risiko yang tidak dapat diterima, mereka perlu segera menghentikan penanganan tersebut.

Seterusnya, pada 2 Mei 2025, Kod Amalan (Codes of Practice) untuk penyedia model AI umum (GPAI) akan diterbitkan. Pengusaha perlu mengambil tindakan berdasarkan kod amalan ini.

Kemudian, pada 2 Ogos 2025, peruntukan berkaitan ‘Model GPAI’ dan ‘Hukuman’ akan diterapkan, dan pelantikan pihak berkuasa yang berwenang akan dilakukan di setiap negara anggota. Pada peringkat ini, pengusaha yang menyediakan model GPAI perlu mematuhi peraturan yang berkaitan.

Pada 2 Februari 2026, garis panduan berkaitan dengan kaedah pelaksanaan sistem AI berdasarkan Undang-Undang Pengawalseliaan AI akan diterbitkan. Pada masa yang sama, pemantauan pasca-pasaran untuk sistem AI berisiko tinggi akan diwajibkan, dan struktur yang sesuai untuk mematuhi ini diperlukan.

Lebih lanjut, pada 2 Ogos 2026, peruntukan berkaitan ‘Sistem AI Berisiko Tinggi’ yang tercatat dalam Lampiran III akan diterapkan. Pada ketika ini, negara anggota perlu menubuhkan sandbox pengawalseliaan AI dan memastikan pematuhan terhadap sistem AI berisiko tinggi yang terlibat.

Akhirnya, pada 2 Ogos 2027, peruntukan berkaitan ‘Sistem AI Berisiko Tinggi’ yang tercatat dalam Lampiran I akan diterapkan. Ini mengwajibkan pematuhan terhadap peraturan sistem AI yang ditetapkan dalam Lampiran I.

Dengan cara ini, Undang-Undang Pengawalseliaan AI akan dilaksanakan secara berperingkat selama beberapa tahun, dengan peraturan yang diterapkan secara berperingkat berdasarkan keparahan risiko. Pengusaha perlu memahami dengan tepat setiap tarikh penerapan dan melaksanakan tindakan yang sesuai dengan sistem AI yang terlibat.

Artikel berkaitan: Apa Status dan Prospek Undang-Undang Pengawalseliaan AI di EU? Analisis Pengaruhnya terhadap Syarikat Jepun[ja]

Panduan Tindakan oleh Firma Kami

Firma Guaman Monolith merupakan firma yang memiliki pengalaman luas dalam IT, khususnya internet dan undang-undang. Kami menyediakan perkhidmatan undang-undang yang unik dan efektif dengan menggabungkan kepakaran dalam kedua-dua bidang ini.

Bisnes AI mengandungi banyak risiko legal, dan sokongan daripada peguam yang mahir dalam isu-isu legal berkaitan AI adalah sangat penting. Firma kami, dengan pasukan peguam yang mahir dalam AI dan jurutera, menyediakan sokongan legal yang canggih untuk bisnes AI termasuk ChatGPT, seperti pembuatan kontrak, penilaian kesahihan model bisnes, perlindungan hak kekayaan intelek, dan penanganan privasi. Sila rujuk artikel di bawah untuk maklumat lanjut.

Bidang yang ditangani oleh Firma Guaman Monolith: Perundangan AI (termasuk ChatGPT dan lain-lain)[ja]

Category: IT